El auge de modelos conversacionales basados en Inteligencia Artificial (IA) despertó distintos interrogantes sobre sus capacidades y limitaciones, y uno de los puntos más discutidos es el relacionado con la interpretación y, eventualmente, imitación de emociones humanas. Y teniendo en cuenta esto, una empresa tecnológica desarrolló un modelo enfocado precisamente en realizar lecturas de las emociones de sus usuarios.

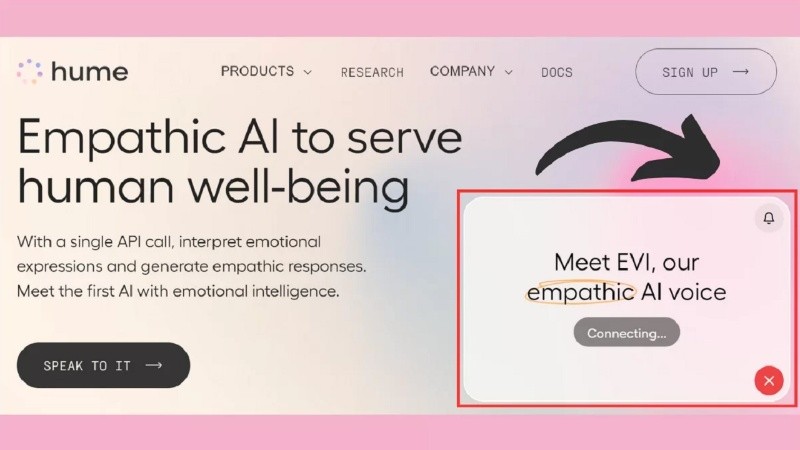

Hume AI, la compañía detrás del chatbot bautizado como Empathic Voice Interface (EVI), define a esta herramienta como "la primera IA emocionalmente inteligente". Lo que crearon funciona como un chatbot conversacional, ya famosos desde que ChatGPT se volvió una aplicación de uso cotidiano para millones de personas, con la particularidad de que –según sus desarrolladores– es capaz de identificar y examinar las emociones de quienes los utilizan para dar respuestas personalizadas.

"Basados en más de 10 años de investigación, nuestros modelos capturan instantáneamente los matices de las expresiones en audio, video e imágenes. Risas teñidas de incomodidad, suspiros de alivio, miradas nostálgicas y más", explica en su web oficial el equipo de Hume.

La herramienta escucha lo que le dice el usuario, hace una transcripción y luego devuelve una respuesta enumerando las emociones registradas, con detalles adicionales sobre cada una. Además de registrar si el usuario está triste, preocupado, emocionado, angustiado, entusiasmado o dubitativo, el modelo de IA se expresa con "empatía".

De acuerdo con el sitio, EVI puede registrar más de 24 expresiones emocionales diferentes para adaptarse en su conversación con seres humanos, basándose en distintas "dimensiones de expresión en tonos vocales, prosodia del habla, expresiones faciales" y otros parámetros.

El modelo fue entrenado con datos de millones de conversaciones humanas de todo el mundo para capturar la tonalidad, los reflejos y los sentimientos humanos, y las respuestas se optimizan aún más en tiempo real según el estado emocional del usuario.

De acuerdo a la información oficial, los desarrolladores pueden utilizar EVI como interfaz para cualquier aplicación a través de su API. En cuanto al acceso para el público general, el sitio oficial indica que se habilitará en abril de 2024.

Cómo detecta y procesa las emociones la IA de Hume