El 27 de noviembre de 2020, el principal científico nuclear de Irán, Mohsen Fakhrizadeh, se trasladaba en un convoy por las afueras de Teherán cuando los vehículos se detuvieron a inspeccionar un impacto que habían sentido. En ese momento, una ametralladora montada en la caja de una camioneta Nissan oculta a unos 150 metros de allí, equipada con un sistema de reconocimiento facial y controlada satelitalmente, abrió fuego con precisión letal sobre Fakhrizadeh una vez identificado el blanco.

El arma se centró únicamente en el rostro de Fakhrizadeh. “Su esposa, que estaba a tan solo 25 centímetros de él, no recibió ningún disparo”, declaró el general de brigada Ali Fadavi, subcomandante de la Guardia Revolucionaria iraní. Irán culpó a Israel y a un grupo opositor exiliado por el ataque, y el ayatolá Ali Jamenei, líder supremo de Irán, prometió vengar el asesinato, aunque Israel nunca confirmó ni negó su responsabilidad.

Previamente, en marzo de 2020, durante la guerra civil en Libia, el Gobierno de Acuerdo Nacional (GNA), reconocido por la ONU, lanzó la operación “Tormenta de Paz”, una ofensiva contra las fuerzas del Ejército Nacional Libio (LNA), liderado por el mariscal Khalifa Haftar. El objetivo era recuperar el control del oeste del país, y para ello contó con el apoyo militar de Turquía, que proporcionó armas, asesores y mercenarios al GNA. Entre el equipo provisto se encontraban los drones Kargu-2, fabricados por la empresa turca STM.

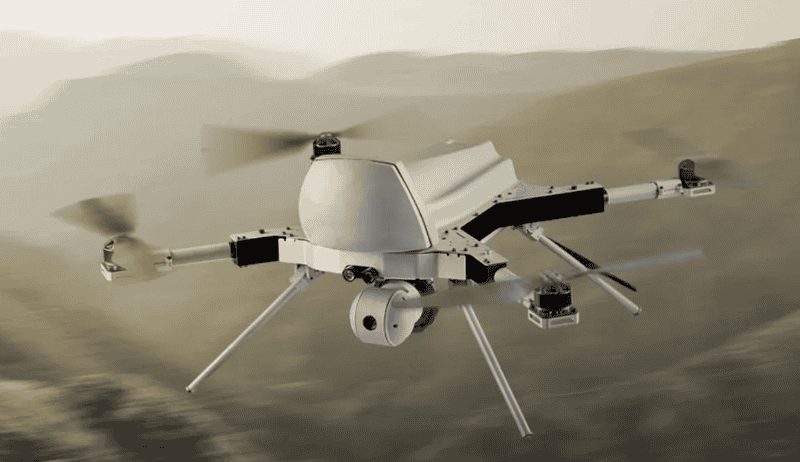

Los drones Kargu-2 son sistemas aéreos no tripulados (UAS) capaces de operar tanto en modo manual, dirigido por un operador, como de manera completamente autónoma. Cuentan con cámaras electro-ópticas, cámaras infrarrojas, LiDAR (una tecnología que utiliza láser para medir distancias y crear mapas tridimensionales de objetos y el entorno) y un sistema de visión computada para identificar a sus objetivos. Está diseñado para ser un arma antipersonal capaz de seleccionar y atacar objetivos humanos basándose únicamente en la clasificación de objetos mediante inteligencia artificial.

Estos drones pueden portar una carga explosiva de hasta dos kilogramos, alcanzar una velocidad máxima de 144 kilómetros por hora y, gracias a los algoritmos de aprendizaje automático integrados en la plataforma, pueden utilizarse tanto contra elementos estáticos como en movimiento sin requerir la intervención humana. El sistema identifica su blanco y lleva adelante el ataque de manera completamente autónoma, sin necesitar la aprobación de un operador humano. El Kargu-2 es un dron kamikaze, es decir, un dron que se utiliza como un arma suicida que se dirige y explota contra un objetivo.

Y esto fue lo que hicieron durante la operación “Tormenta de Paz”, atacando en enjambre a los tanques y soldados de Haftar que se batían en retirada. Así, este dron de fabricación turca, se convirtió en el primer sistema de armas de la historia en ejecutar un ataque contra su blanco sin intervención humana de ningún tipo, según confirma un informe presentado en marzo de 2021 ante el Consejo de Seguridad de las Naciones Unidas.

Este hecho tiene una relevancia trascendental no solo en el desarrollo de las armas autónomas, sino también en la historia de la humanidad, ya que marca el inicio de un nuevo capítulo donde la decisión de poner fin a vidas humanas no depende de la voluntad de otro ser humano, sino que recae completamente en un sistema informático. La idea de que una máquina pueda tomar decisiones para matar plantea cuestiones extremadamente complejas en lo que respecta a la ética de los conflictos armados y su evolución a lo largo de los siglos.

En 2015, el Future of Life Institute, una organización sin fines de lucro dedicada a reducir los riesgos existenciales asociados con el avance de la tecnología, publicó una carta en la que solicitaba la prohibición de la fabricación de armas autónomas capaces de seleccionar y atacar objetivos sin intervención humana. Este escrito, que alertaba sobre los posibles peligros de tales armas para la humanidad, fue firmada por destacados expertos en IA, robótica, física, ética y otros campos, incluyendo al físico y divulgador científico británico Stephen Hawkings, Steve Wozniak, el cofundador de Apple, el lingüista y filósofo Noam Chomsky, y Elon Musk, fundador de Tesla, SpaceX y Neuralink.

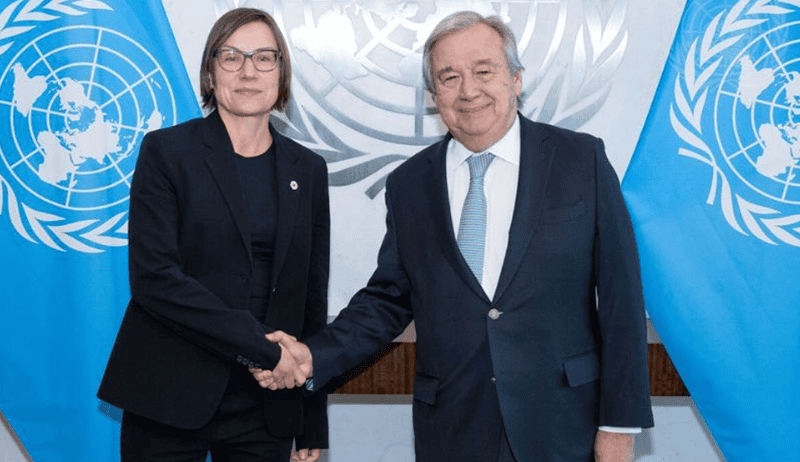

El pasado jueves 5 de octubre, el Secretario General de las Naciones Unidas, António Guterres y Mirjana Spoljaric, presidenta de la Cruza Roja Internacional, instaron a las autoridades políticos a regular con urgencia los sistemas de armas autónomas. Guterres y Spoljaric argumentaron que la introducción de dichos sistemas podría dar lugar a un aumento de la violencia, ya que promueven la idea de que existe un riesgo mínimo tanto para las fuerzas militares como para la población civil, lo que podría eliminar los escrúpulos para involucrarse en conflictos.

“Instamos a los líderes mundiales a iniciar negociaciones sobre un nuevo instrumento jurídicamente vinculante para establecer prohibiciones y restricciones claras sobre los sistemas de armas autónomas y concluir dichas negociaciones para 2026. Instamos a los Estados miembros a tomar medidas decisivas ahora para proteger a la humanidad”, resaltaron Spoljaric y Guterres. Además, señalaron que “el derecho internacional debería prohibir las máquinas con el poder y la discreción de acabar con vidas sin intervención humana”, sobre las que actualmente no existe ninguna regulación.

Esto marca el inicio de un nuevo capítulo donde la decisión de poner fin a vidas humanas no depende de la voluntad de otro ser humano, sino que recae completamente en un sistema informático

Durante la Operación “Guardián de los Muros”, en mayo de 2021, las Fuerzas de Defensa Israelíes (IDF) utilizaron por primera vez el sistema Alchemist, una plataforma de inteligencia artificial que centraliza toda las información sobre la actividad de grupos terroristas en Gaza, como la posición de los lanzadores de cohetes, túneles, depósitos de municiones y ubicación de los líderes. Alchemist utiliza algoritmos de aprendizaje automático para analizar y recomendar objetivos para llevar adelante ataques aéreos, en base a los datos proporcionados por otras fuentes de inteligencia, como imágenes de drones, satélites, cámaras, señales electrónicas y agencias como el Mossad y la Shin Bet.

A continuación, otro sistema de IA llamado Fire Factory se encarga de asignar drones y aviones, además de coordinar la logística de guerra, como el cálculo y transporte de municiones, combustible y personal necesario para llevar a cabo las misiones. Finalmente, propone un cronograma de acción. Todo el sistema está bajo supervisión de operadores humanos, quienes deben aprobar las decisiones tomadas por la inteligencia artificial.

La IA también se ha utilizado para mejorar la sofisticada plataforma de defensa aérea israelí Iron Dome (Cúpula de Hierro), potenciando su capacidad para interceptar y neutralizar ataques con cohetes a partir de tecnologías de predicción de trayectoria y punto de impacto en tiempo real. El sistema de control de armas decide si un proyectil es una amenaza teniendo en cuenta variables como la velocidad, las condiciones climáticas y áreas pobladas. Según algunas fuentes, la IA ha ayudado a aumentar la tasa de éxito del Iron Dome a más del 90%.

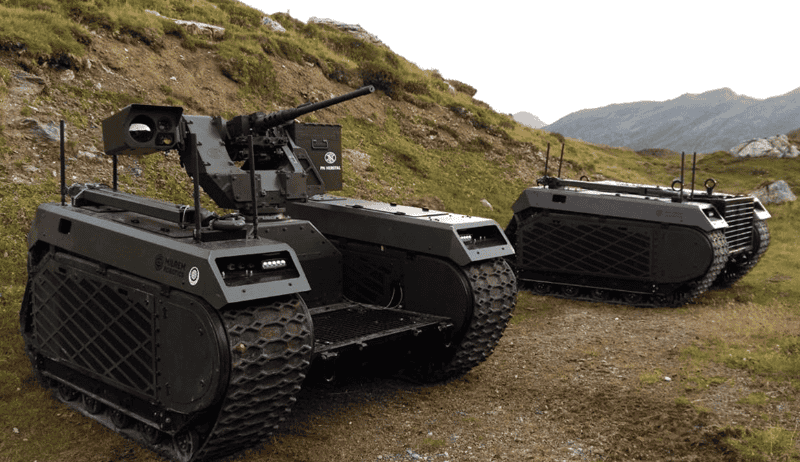

La guerra entre Rusia y Ucrania ha acelerado el desarrollo de diversos sistemas de armas letales autónomas. En enero de este año, el ejército de los Estados Unidos actualizó una directiva del Departamento de Defensa con el fin de mantener la ventaja tecnológica en el desarrollo de los denominados robots asesinos (killer robots), capaces de identificar, seleccionar y atacar objetivos humanos sin intervención humana significativa. Al mismo tiempo, Rusia anunció sus planes para desarrollar una nueva versión de combate de su robot de reconocimiento MARKER, diseñado específicamente para detectar y destruir tanques como el norteamericano M1 Abrams y el alemán Leopard 2.

Según un informe del Instituto Internacional de Estudios para la Paz de Estocolmo (SIPRI) publicado en junio d. este año, al menos otros 14 países poseen o están adquiriendo sistemas de armas autónomas, entre ellos, China, Reino Unido, Francia, Israel, Corea del Sur, Turquía, Irán, India, Pakistán, Arabia Saudita, Emiratos Árabes Unidos, Egipto, Australia y Japón.

Los países más poderosos del mundo están inmersos en una nueva carrera armamentística en la que las fronteras se vuelven cada vez más difusas. Además de la deshumanización y el poder letal de esta nueva generación de armas, se suma el riesgo de que esta peligrosa tecnología sea robada por ciberdelincuentes y caiga en manos de grupos terroristas y otras organizaciones fuera del control gubernamental. A medida que las armas con inteligencia artificial comienzan a desplegarse en los campos de batalla, la amenaza para la humanidad crece exponencialmente, y más allá de las buenas intenciones que puedan tener algunos líderes mundiales, tal vez ya sea demasiado tarde para dar marcha atrás.