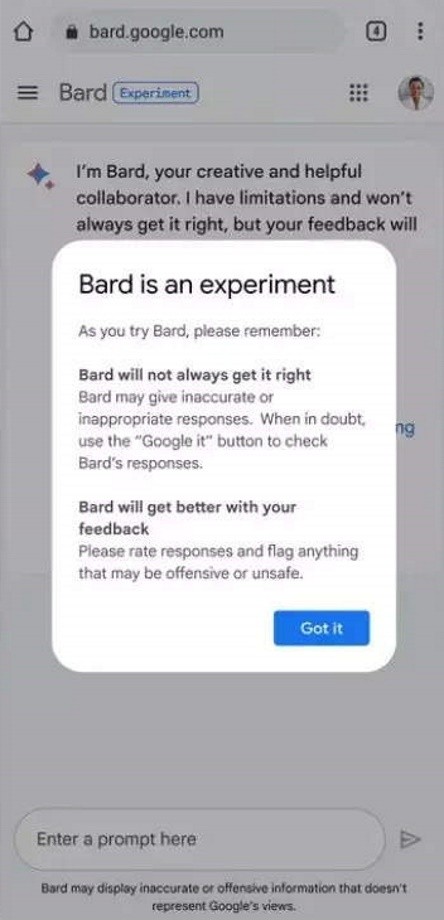

Los empleados de Google recibieron una serie de recomendaciones para utilizar de manera segura la herramienta Bard, el chatbot de inteligencia artificial (IA) desarrollado por la compañía propiedad de Alphabet Inc. La empresa también indicó que las advertencias de su guía de uso son válidas para aplicaciones similares de la competencia, como ChatGPT.

La matriz de Google solicitó con urgencia a sus trabajadores no ingresar ningún tipo de material confidencial en estos chats que funcionan con IA, según revelaron desde la propia compañía, inform. Reuters.

De acuerdo con un grupo de investigadores de la empresa, la IA es capaz de reproducir todos los datos que haya absorbido durante su entrenamiento, es decir, los intercambios que mantiene con los usuarios del chatbot. Y puesto que hay desarrolladores humanos que pueden revisar esa información, esto atenta contra la política sobre la protección de datos de Google.

Por esa razón, Alphabet le indicó a sus ingenieros que eviten el uso de fragmentos de código que hayan sido generados directamente por los chatbots como ChatGPT.

Los chatbots, entre ellos Bard, son programas con apariencia humana que utilizan la llamada inteligencia artificial generativa para mantener conversaciones con los usuarios y responder a innumerables indicaciones.

Estas recomendaciones reflejan lo que está ocurriendo puertas adentro en las grandes tecnológicas, en donde el surgimiento de estos sistemas incentivó la discusión sobre los nuevos estándares de seguridad que deberían adoptarse. Además, Google está buscando aumentar la confianza y, por ende, los beneficios comerciales generados a partir del uso de su chatbot.

Según una encuesta realizada por Fishbowl a 12.000 personas de las principales empresas de Estados Unidos, alrededor del 43% de los profesionales utilizaban a menudo ChatGPT u otras aplicaciones de IA sin decirle a sus jefes.

Los chatbots de inteligencia artificial pueden utilizarse para redactar correos electrónicos, documentos y hasta código de programación, pero estos contenidos pueden contener errores e incluso información confidencial o protegida por derechos de autor.

Como respuesta a esto, varias compañías comenzaron a lanzar soluciones de pago para que sus clientes puedan asegurar sus datos y que estos no terminen en modelos públicos de IA.